2011年01月07日

Autodesk 3December 2010 レポートの2回目は、デジタルドメイン社でLead Technical Directorを務める三橋忠央氏のデジタルヒューマンについての講容をレポートする。

このセッションでは、フォトリアリスティックな人間をデジタルでいかに作り上げるかをテーマとして、三橋氏が参加した映画作品を例にとりながら様々なテクニックが紹介された。 「マトリックス・リローデッド」、「マトリックス・レボリューションズ」、「ベンジャミン・バトン」 そして 「トロン : レガシー」 まで、世界 No.1 クラスの圧倒的なテクノロジーが披露されたこのセッションを再現する。

デジタルドメイン社でLead Technical Directorを務める三橋忠央氏

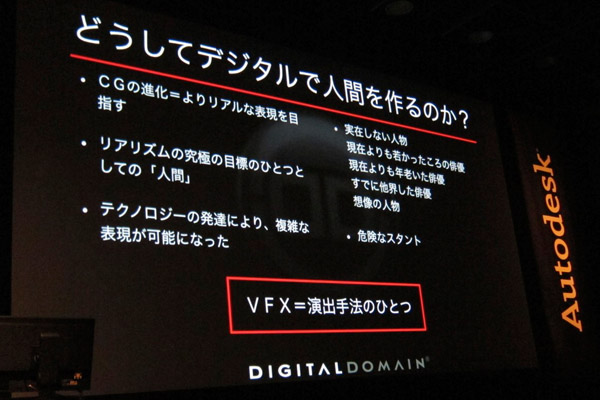

なぜデジタルでフォトリアルな人間を作るのか?

「デジタル・ヒューマン~フォトリアリズムの追究~」とタイトルにあるとおり、どうしてデジタルでフォトリアルな人間を作るのか?という話ですが、僕が思いつく理由としてはこんなものがあります。

① 現在よりも若かった頃の俳優

これは僕らが「トロン:レガシー」の中で最近やったことですが、ジェフ・ブリッジス、彼は今60歳ぐらいですけど、最初の映画に出てた時は30代半ばだったんですが、その頃の風貌を作るのは、やはり若返りのメークアップをしても無理があるので、まるまるいちから作ってしまったほうが早いということです。

② 現在より年老いた俳優

これは「ベンジャミン・バトン」で僕らがやったことですね。

③ すでに他界した俳優

業界にいるとよく聞こえてくるうわさ話として、僕がよく聴くのはブルース・リーを復活させようという話。いろいろ事情があって実現しないみたいですが、そんなことも可能になる技術です。

④ 想像の人物

これも、フォトリアルに作りあげてしまうことも可能です。僕がやってみたいのは、例えば「うる星やつら」のラムちゃんを作ってみたいですね。

⑤ 危険なスタント

通常はスタントマンがやりますが、もし本当にフォトリアルな顔を作ることができれば、デジタルで作った人間が危険なスタントをやりつつ、カメラワーク的にも顔がよくわかるというデザインも可能になってくると思います。

デジタルで人間を作る大きな理由は「実在しない人物」や「危険なスタント」

デジタルで人間を作るということはVFXの大きな範疇の一つですが、VFXというのはいわゆる演出手法の一つなんですね。監督はストーリーを映像で語るわけですが、それを手助けしているのが、照明、カメラワーク、音などの要素。VFXはそういう演出手法と同じなんですね。VFXの技術がどんどん進歩して、今まで無理だった表現が可能になるということは非常に意義のあることだと思います。

フォトリアルな人間を作る時に、いちばんの障害となるのは、人間は非常に複雑であるということです。CGで作った人間というのは、ほんの少し何かが違うだけでも、見る人は「あれ? なんかにせものっぽいぞ」って気づいてしまうんですね。ロボットとかエイリアンだと、誰も見たことがないのでごまかしが効くんですが、人間はそういうわけにはいかない。たとえばリアルな笑顔の状態ができたとしても、それだけではダメで、顔の筋肉がどういうふうに変化して笑顔になるのかまで再現しないといけない。

ディテールのリアリティを追求するための手法として、キャプチャリングが重要です。テクスチャであれば写真、形状モデルであれば3Dスキャン、アニメーションはモーションキャプチャ、環境光ならHDR環境マップといった具合に、現実世界からたくさんのサンプルを取り込む。そして光や動きなどを徹底的に物理法則に則ってシミュレーションするというアプローチで、現実世界を模倣するわけですね。

「マトリックス・リローデッド」でのデジタルヒューマンのアプローチ

ここで「マトリックス・リローデッド」を見ていただきます(クリップを上映)。この作品の制作は10年近く前の話なので、今だったら簡単にできてしまうようなこともたくさんあるんですが、デジタルヒューマンの技術がどのように進化してきたのかということを知っていただくためにもお話ししておきます。これが僕のキャリアの中で初めてデジタルヒューマンに挑戦した作品で、当時はESC Entertainmentという会社に在籍していました。

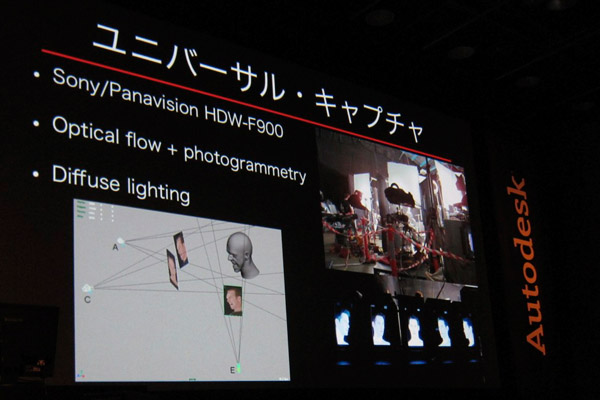

この映画で開発したのはユニバーサル・キャプチャという、顔の動きをキャプチャする方法です。通常だと小さいピンポンボールみたいなものを顔にいっぱいくっつけてキャプチャするのですが、このシステムが画期的だったのは一切マーカーを使わないんですね。非常に高解像度のカメラで複数のアングルから、表情の動きを撮影します。これが実際のセットアップの写真です。カメラはHDW-F900というカメラを5台使っています。各アングルからの画像をOptical Flowという技術で解析すると、このカメラのこのピクセルは、あのカメラのあのピクセルに対応しているということが判断できる。後は三角法をつかえば、三次元的に再構築できるというわけです。

ユニバーサル・キャプチャは俳優を複数のカメラで撮影し、3次元的に再構築する技術だ

これでモデルとテクスチャが得られたんですが、実際にライトを置いて照らした時に、洋服の生地や人間の肌がそれらしく見えなければいけない。質感の問題ですね。それを表現するにはBRDF(双方向反射率分布関数)を計測しないとならない。当時、サーフェスオプティクスという会社がBRDFを計測できる機械を開発していて、これが70万ドルもしました。そこで、その会社に協力を依頼して、スーツの生地などサンプルをたくさん送って、いろんな角度から光を照らして、どちらの方向にどれくらい反射したかをデータ化してもらい、それMayaに読み込んで三次元的にビジュアライズするためのプラグインを書きました。

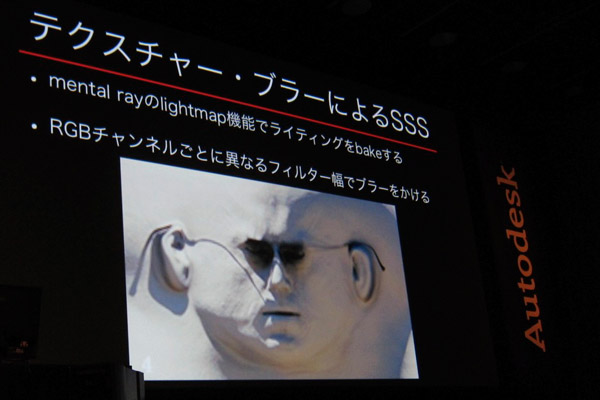

当時、人間の肌をデータで再現するという試みがされていなくて、お手本がなかったので試行錯誤していました。人間の肌のサブサーフェイス・スキャタリング(光が半透明な物体の表面を透過し、内部で散乱した後に表面から出て行くメカニズム)がキーになることは見当がついたのですが、まさか人間の肌を切り抜いてそれをサンプルしてもらうわけにいかないので、サブサーフェイス・スキャタリングを擬似的に再現する方法を考案しました。Mental RayのLight Mapという機能で顔に当たっている光を記録し、それを二次元のテクスチャーに落とし込んでブラーをかけるという手法です。後にゲームコミュニティで採用されまして、NVIDIAがフォトリアルな人間の顔がリアルタイムで動くというデモンストレーションをしていたと思います。

今では当たり前のサブサーフェイス・スキャタリングを擬似的に再現した

次はIBL、イメージ・ベースド・ライティングです。IBLは実際にその場所に行って、HDR(ハイダイナミックレンジ)の360°パノラマ写真を撮ります。HDRは一枚の画像で、非常に明るいところから暗いところまでの光の情報を全部保持しているというマップで、今だったらそれを使って絵を得ますが、10年くらい前はそれでは時間がかかりすぎるということで、もっと早くできる方法としてこの画像をライトに変換する方法を考案しました。光の情報を、無限遠からやってくるディレクショナルライトに置き換えて、非常に明るい部分とそうでない部分に分けて別々に書き出し、明るさを個別に調整できるように工夫しました。

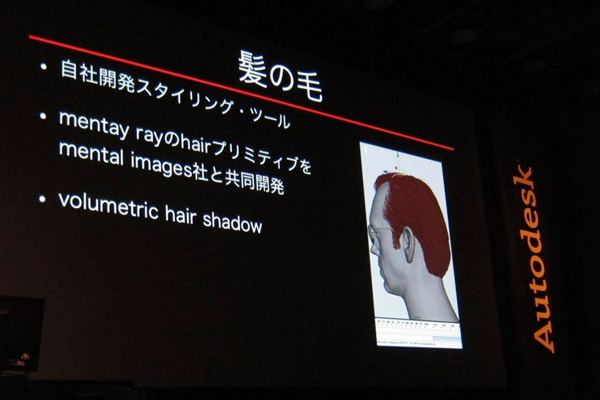

次に髪の毛についてです。当時はMaya Fur(短い毛、毛皮などを生成するツール)はあったんですが、Maya Hair(長い髪を生成するツール)はありませんでした。そこでMaya Furを使ってエージェント・スミスの髪型を作ろうとしたんですが、一週間ぐらい粘ってちょっと気がくるいそうになって…。これじゃだめだということで、もっと直感的に髪型を定義できるMayaプラグインを開発しました。また、髪の毛を効率的にレンダリングできるHair PrimitiveというツールをMental Image社と共同開発したり、髪の毛の影をリアルに作るVolumetric Hair Shadowというツールも開発しました。

髪の毛を描くために、スタイリング・ツールをはじめ様々なツールを開発した

ここまでが「マトリックス・リローデッド」についての話で、つづいて「マトリックス・レボリューションズ」です。この作品で特に取り上げたいのが「スーパー・パンチ」と呼ばれるショット。スーパースローモーションで、主人公のネオがエージェント・スミスの顔面を殴って、顔面が変形するという完全フルCGのショットです。この作品が公開されたのは2003年ですから、非常にチャレンジングなショットでした。顔はユニバーサルキャプチャを使っていません。顔の変形はすべて「手付け」で動きを付けたもので、とても優秀なアーティストが作ってくれた表情です。背景のボケは、レンズを光学的に正確にシミュレーションをするLens Shaderというものを開発しまして、とても計算に時間がかかったんですが、それに見合うだけの美しい結果が出たんじゃないかと思っています。

「ベンジャミン・バトン」「トロン:レガシー」での新たなチャレンジ

12月17日に公開された「トロン:レガシー」。(C) Disney Enterprises, Inc. All Rights Reserved.

次は「ベンジャミン・バトン」についてです。この映画は、僕がデジタル・ドメインに移籍するきっかけとなった作品です。「マトリックス」シリーズとのいちばん大きな違いは、80歳代の風貌のブラッド・ピットは存在していないということです。ネオもエージェント・スミスも実際の俳優を目標としてデジタルヒューマンを作り上げればよかったんですけど、これは目標が存在していないので、目に見えないゴールに向かっていくような、そういう感じのプロジェクトでした。

まず、エモーションキャプチャと呼んでいる技術なんですけれど、何が肝かというと、キャプチャされた顔の動きを編集できるようになったということです。今までは、キャプチャした表情がいまいちだから、もっとにっこりさせてくれってアニメーターに言うと、ポイント1個1個をすべて修正しなくてはいけないので、現実的じゃないんですね。どこか1個のポイントを動かしたら、その周りも自然な感じで動かさないと不自然な感じになる。「ベンジャミン・バトン」では、それを編集できるようにしたんです。

そして、画面に見えているのは80歳のブラッド・ピットでも、実際にはブラッド・ピット本人の演技をキャプチャするわけです。これの何が問題かというと、80歳代の彼と現在の彼とでは、顔の形状が違うので1対1でマッピングできないんですね。そのギャップを埋めるには、顔の筋肉の動き、つまり表情がどう作られるのかを研究したFACSと呼ばれるシステムに基づいて計算する必要がある。FACSではAの筋肉が動くとBの筋肉がこれぐらい動くということがわかっているので、その逆にBを動かすとAはこれだけ動くという計算をするわけです。しかも、アニメーターがスライダが上げ下げするだけで、顔の表情を作り出せるようにしています。これによって、アーティストたちがアーティスティックなことだけを考えて作業できるという環境が構築されました。

ここからライティングの話になります。この映画では、ライトステージと呼ばれる機材を利用して、CGのライティングを考えました。ライトステージには上下左右にたくさんライトが配置されていて、それを一つ一つ自由にオン、オフできます。あるオブジェクトがある角度から照らされた時にどういうふうに見えるかがわかるわけです。このライトステージに、マケットと呼ばれるシリコン製の頭部を置いてライティングを研究し、それを元にCGのライティングを組み立てたのですが、やはりマケットはマケットでしかないし血も通ってないので、マケットにマッチさせるだけでは生きている感じがしなかった。最終的には、自分たちのアーティスティックなセンスで、より人体に近づけるように調整しました。

従来のイメージ・ベースド・ライティングの最大の欠点は、僕が思うにライトの位置や光の強さなどを編集できないことだと思います。これを一歩押し進めたシステムを僕をはじめ数人で開発し、ライトキットと名付けて2009年のSIGGRAPHで発表しました。何がキーかというと、シーンの中に存在する光源を環境マップから抜き出して、実際にどこにあったかという場所にエリアライト(面光源)を置いて、HDR画像にマッピングするんです。エリアライトを使うことで、すごくリアルな表現ができましたし、直感的な操作が可能になりました。実写とCGを合成した時に、このライトはこうしておけばよかったと思っても、今までは変更が難しかったのですが、このシステムを使うことで、ライトを動かすなど直感的なエディティングが可能になりました。

最後は「トロン:レガシー」の話です。冒頭で言ったように、この映画には30代半ばぐらいのジェフ・ブリッジスが登場します。頭部は全部CGでできています。基本的なテクノロジーは「ベンジャミン・バトン」で開発したものが主なんですけれど、今までなかったチャレンジがありました。というのも、80歳代のブラッド・ピットは誰も見たことがないので、僕らが提示したイメージをみんなが納得してくれたと思いますが、30代半ばのジェフ・ブリッジスはたくさんの人が知っている顔なんですね。ターゲットが明確にあるので、それを作らなければいけない。でも、その顔はもう現実には存在していない。足りない部分は僕らが補っていかなければいけないというのは大変なところでした。

「ベンジャミン・バトン」の老人よりももっと血が通っている感じ、若々しく健康的な感じを表現しなければいけなかったんですけれど、それはまだまだ技術的に難しい部分で、とくにサブサーフェイス・スキャッタリングのアルゴリズムがどうしてもロウ人形っぽい質感になっていまうところがあり、その調整に手間取りました。髪の毛に関しても本数が多いので、いろいろな髪の動き、髪型のバリエーション、そういうところが10倍、20倍くらい複雑だったと思います。

最後にまとめますと、ほんとにしつこく言いますが、「キャプチャ! キャプチャ! キャプチャ!」。とにかくキャプチャして、現実世界にあるディテールをどんどん使いましょう。そのキャプチャされたデータをどういうふうに扱っていくかに関しては、要は物理的に正しい扱いをする、現実世界で起こっていることとなるべく近い扱い方をして作りましょうということです。

そして、今言ったことと相反するように聞こえるかもしれませんが、キャプチャしたものとまったく同じものを作り上げるだけでは魅力が生まれない。映画というのは芸術作品で、アーティストたちがそれをより魅力的なものに仕上げていくわけで、彼らの力は必要不可欠なんです。彼らの能力を最大限に発揮できるような仕組み、現実からキャプチャされたデータをもとに彼らの調整が施せるようなそういう柔軟な仕組み、それを可能にすることがいちばん求められているアプローチなのかなと考えています。